[CMP334] Introducing AWS Inferentia2-based Amazon EC2 Inf2 instances[NEW LAUNCH!]

投稿日: 2022/12/09

11/29 AWSで発表されたEC2 Inf2インスタンスタイプの詳細セッション。

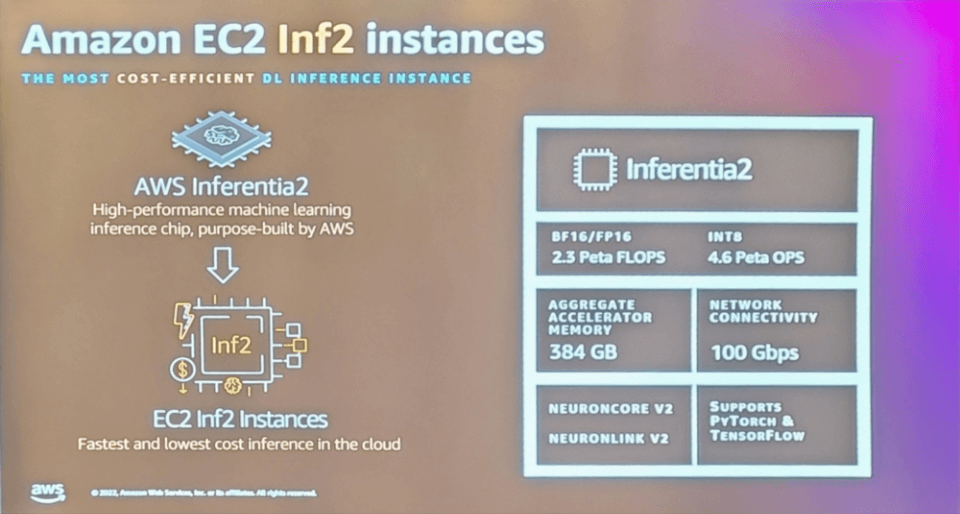

Inf2インスタンスは、AWSによって設計された3番目のDeep Learning(DL)アクセラレータである最大12のAWS Inferentia2で動作します。

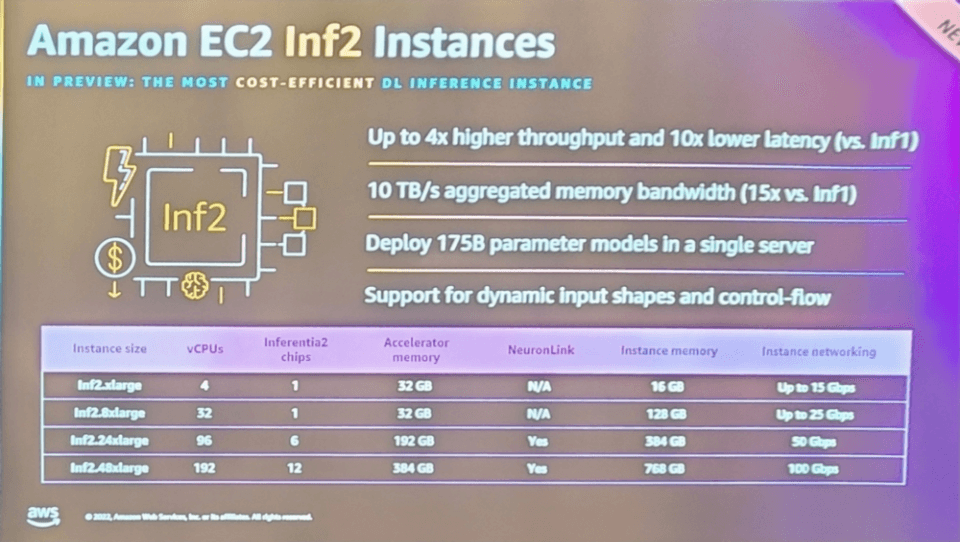

Inf1タイプと比較して最大4倍の高スループットと10倍低い遅延時間と10TBの集約メモリ帯域幅を提供します。

最大のインスタンスサイズであるInf2.48xlargeでは、175Bのパラメータモデルがデプロイ可能です。

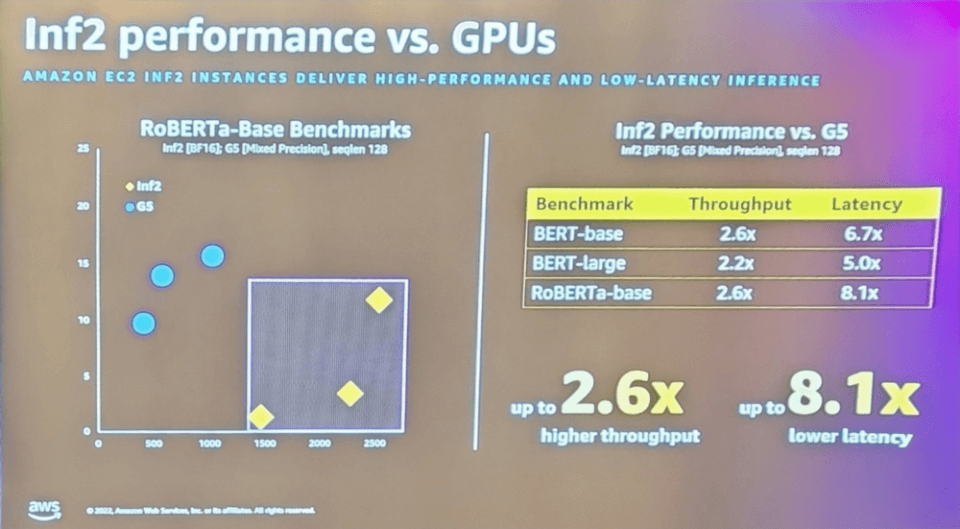

自然言語処理アプリケーションで使用される人気の機械学習モデルであるRoBERTaをベースにしたベンチマークも確認できました。

G5タイプと比較してスループットは2.6倍、遅延時間は8.1倍改善された部分を確認しました。

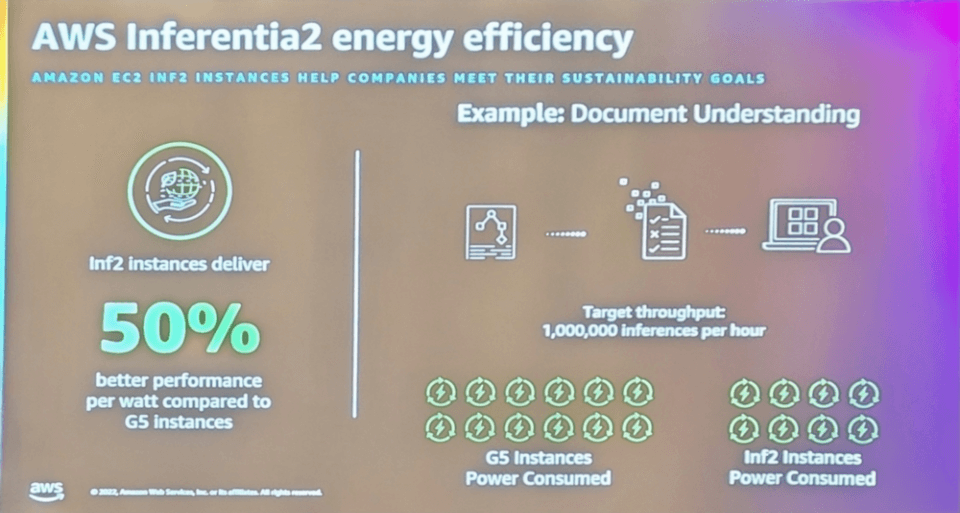

最善の点は、エネルギー効率も備えていることです。

GPU インスタンスに最適化された G5 インスタンスよりワットあたり最大 50% 削減された様子です。

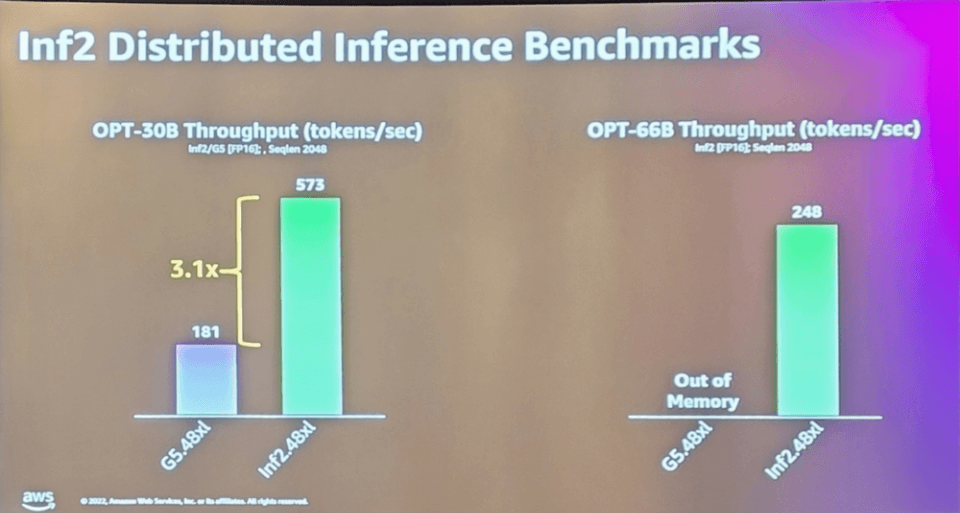

OPT 300億パラメータモデルの場合、Inf2は毎秒573個のトークンを配信するのに対し、G5は毎秒181個のトークンを配信する様子で、3倍以上のスループットの差を示しています。

660億のパラメータモデルでテストすると、G5はメモリの問題が発生しますが、Inf2は依然として高い性能を提供します。

その理由は、最低コストで高い性能と短い遅延時間出力を提供するように設計されたからだと言われています。

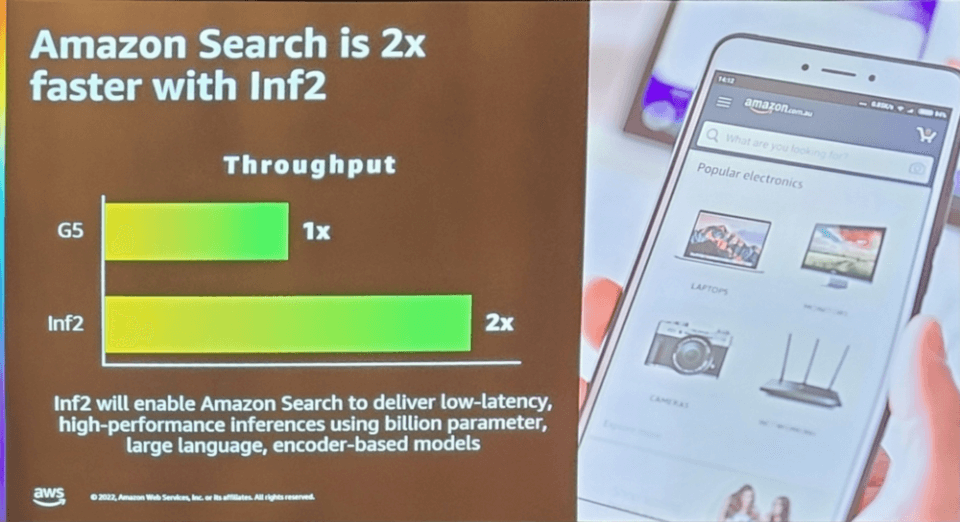

あるユースケースでは、Amazon SearchがInf2で2倍の速さで実行されることがわかりました。

パフォーマンスとユースケースに基づいて、新しいインスタンスタイプであるInf2タイプについて調べました。

発展が驚くべきと思いました。

まだPreview段階でus-east-1、us-east-2リージョンにのみリリースすると言われていますが、GAになればInf1タイプを使用する顧客にとって良い選択肢になるようです。