NVIDIA DGX Systems

NVIDIA DGX™ A100/

NVIDIA DGX STATION™

NVIDIA DGX™ A100/NVIDIA DGX STATION™

【お知らせ】NVIDIA DGX™ A100、NVIDIA DGX STATION™は販売終了となりました。

NVIDIA DGX™ H100に関してはこちらをご覧ください

販売終了

NVIDIA DGX™ A100

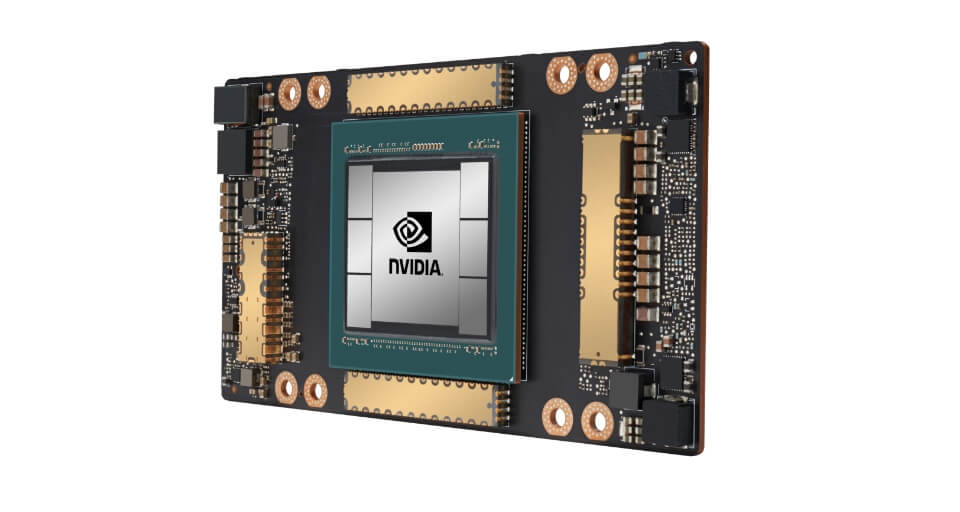

NVIDIA DGX™ A100 はあらゆる AI ワークフローのためのユニバーサル システムであり、前例のない計算処理密度、パフォーマンス、柔軟性を提供する世界初の 5 ペタフロップス AI システムです。NVIDIA DGX™ A100 は世界最先端のアクセラレータ、NVIDIA A100 Tensor コア GPU を備えています。企業はトレーニング、推論、分析ワークロードを、配備が容易でNVIDIA の AI 専門家の支援も受けられる単一の AI インフラストラクチャに統合できます。

データシートは販売当時のものです。

データシートのダウンロードNVIDIA DGX™ A100の特徴

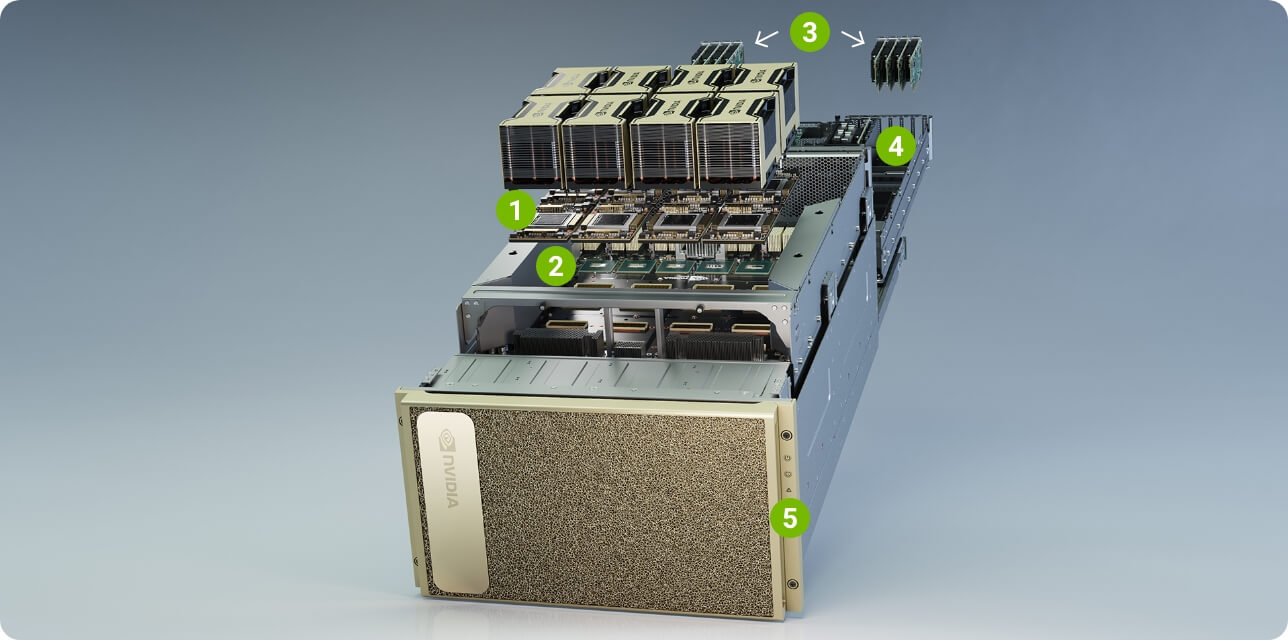

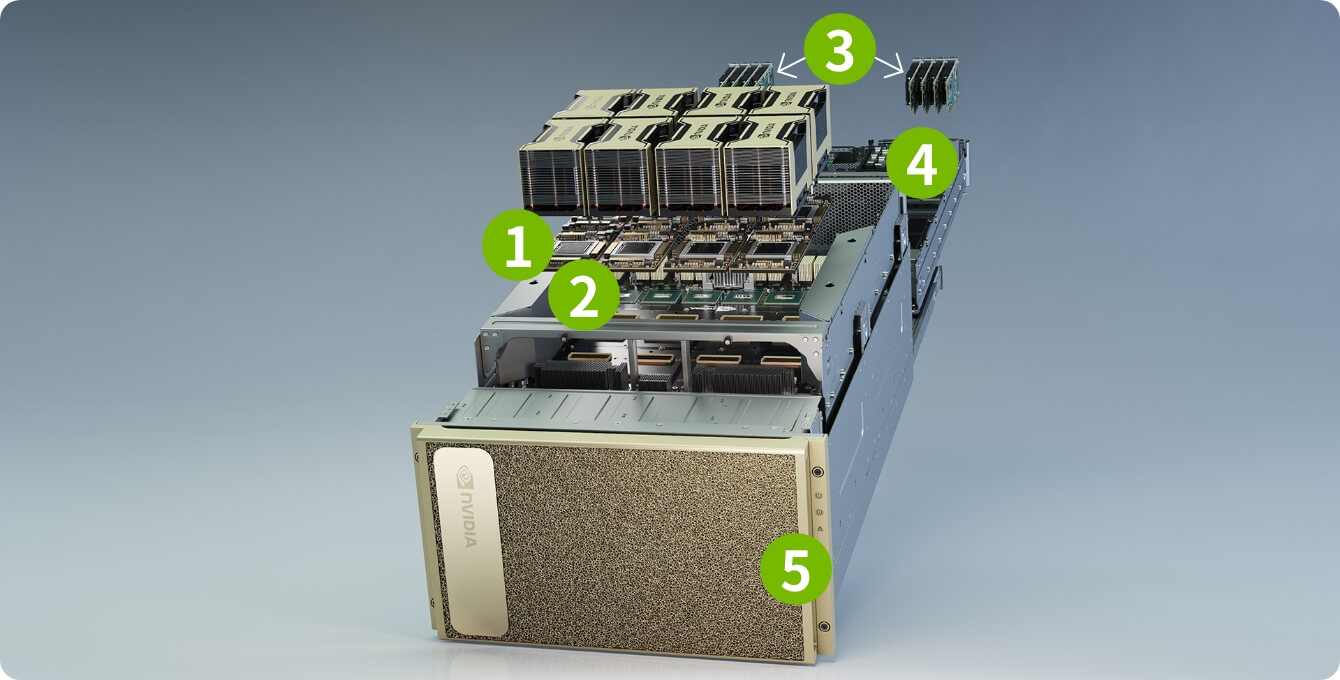

-

1

8つのNVIDIA A100 GPU、

合計GPUメモリ 最大640GBGPU あたり 12の NVLink GPU から

GPU への帯域幅:600GB/秒 -

2

6基のNVIDIA NVSWITCH

双方向の帯域幅:

4.8TB/秒前世代と比較して2倍 -

3

10 MELLANOX CONNECTX-6 200/Gb

ネットワーク インターフェイスピーク時の双方向の帯域幅:500GB/秒

-

4

デュアル64コアAMDCPUと

最大2TBシステムメモリ3.2倍のコアで最も集中的なAIジョブを強化

-

5

最大30TBのGEN4 NVME SSD

ピーク時の帯域幅:

50GB/秒Gen3 NVME SSDより2倍速

NVIDIA A100 Tensor コア GPU

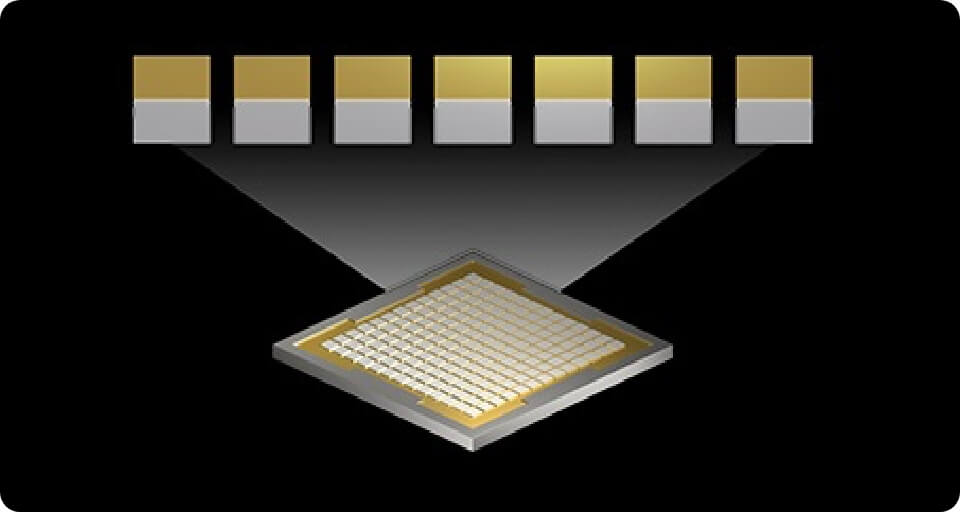

NVIDIA A100 Tensor コア GPU による前例のない高速化をもって、世界で最も困難な計算に AI、データ分析、HPC (ハイ パフォーマンス コンピューティング) で挑むことができます。第 3 世代の NVIDIA Tensor コアにより性能を大幅に向上できるようになり、A100 GPU を効率的に数千までスケール アップできます。また、マルチインスタンス GPU を使用すれば、あらゆるサイズのワークフローを加速するために 7 つの小さな専用インスタンスとして割り当てることができます。

マルチインスタンス GPU (MIG)

MIG を利用することで、NVIDIA DGX™ A100 の 8 つの A100 Gpu を最大 56 個の GPU インスタンスとして構成し、それぞれが独自の高帯域幅メモリ、キャッシュ、コンピューティング コアで完全分離できます。これにより管理者は、複数のワークフローに対してサービス品質 (QoS) が保証された GPU のサイズを適切に設定することができます。

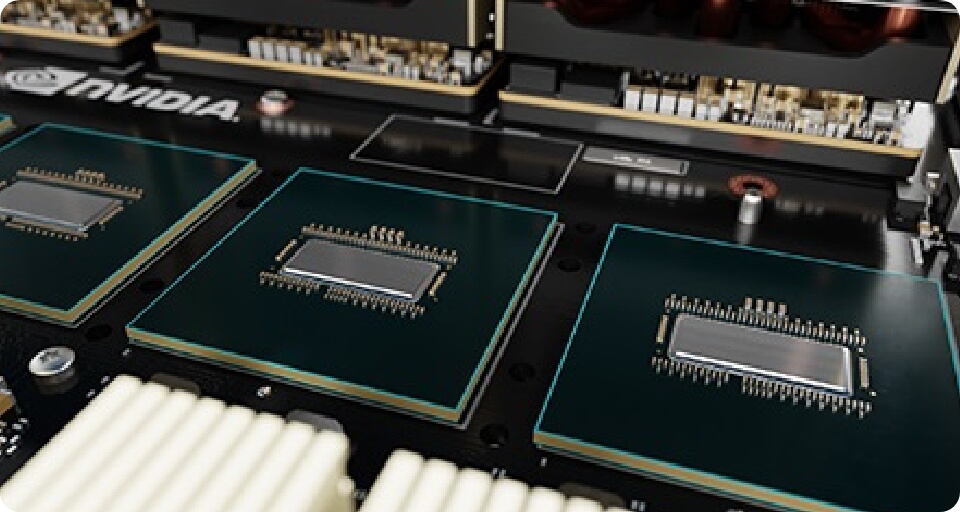

次世代 NVLink と NVSwitch

NVIDIA DGX™ A100 の第 3 世代の NVIDIA® NVLink™ は、GPU から GPU への直接帯域幅を 600 ギガバイト/秒 (GB/s) まで倍増します。これは PCIe Gen4 のほぼ 10 倍に相当します。NVIDIA DGX™ A100 には、前世代と比較して 2 倍の速度を可能にする次世代の NVIDIA NVSwitch™ も搭載されています。

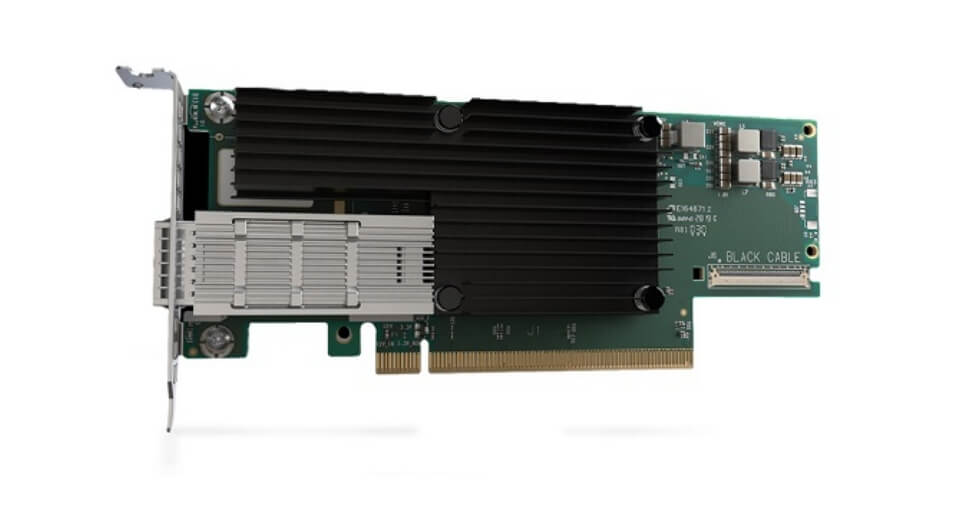

Mellanox ConnectX-6

VPI HDR InfiniBand

NVIDIA DGX™ A100 には最新型の Mellanox ConnectX-6 VPI HDR InfiniBand /イーサネット アダプターが搭載されており、それぞれが 200 ギガビット/秒 (GB/s) で動作し、大規模 AI ワークフロー用の高速ファブリックを形成します。

最適化されたソフトウェア スタック

NVIDIA DGX™ A100 には、AI チューニングされた基本オペレーティング システム、必要となるすべてのシステム ソフトウェア、GPU 対応アプリケーション、トレーニング済みモデル、NGC™ の各種機能など、テスト済みで最適化された DGX ソフトウェア スタックが統合されています。

組み込まれたセキュリティ

NVIDIA DGX™ A100 は、あらゆる主要なハードウェアとソフトウェア コンポーネントを保護するための自動暗号化ドライブ、署名付きソフトウェア コンテナー、安全な管理と監視といったマルチレイヤー アプローチを採用することで、AI 導入において最も信頼性の高いセキュリティ体制を実現します。

世界で最も完全なAI

プラットフォーム

についてはこちら

販売終了

NVIDIA DGX STATION™

NVIDIA DGX Station™ は、データサイエンスチームにAIスーパーコンピューティングをもたらします。これによりデータ センターがなくても、あるいは IT に追加投資しなくても、データ センターのテクノロジがもたらされます。

データシートは販売当時のものです。

データシートのダウンロードNVIDIA DGX Station™ の特徴

-

データ サイエンス チームのための

AIスーパーコンピュータートレーニング、推論、データ分析など全てのワークロードに対応した集中型のAIリソースを複数のユーザーに提供することができます。また、マルチインスタンスGPU(MIG)により、最大28個の独立したGPUデバイスを個々のユーザーやジョブに割り当てることができます。

-

データ センターと同等のパフォーマンス

DGX Station A100は、データセンターの電源や冷却を必要としないサーバグレードのAIシステムです。4つのNVIDIA A100 Tensor Core GPU、サーバグレードの最上位CPU、超高速NVMeストレージ、最先端のPCIe Gen4バスを搭載し、リモート管理も可能なので、サーバのように管理することができます。

-

どこにでも配置できる AI アプライアンス

企業のオフィス、研究所、研究施設、あるいは自宅で働く今日の俊敏なデータサイエンスチームのために設計されており、複雑なインストールや重要なITインフラを必要としません。標準的な壁のコンセントに差し込むだけで、数分で起動し、どこでも作業ができます。

-

より大きく、より高速に

4つの完全に相互接続されたMIG対応のNVIDIA A100 GPUを搭載した世界で唯一のオフィス向けシステムで、NVIDIA® NVLink®を活用することで、システム性能に影響を与えることなく並列ジョブや複数のユーザを実行することができます。完全にGPUに最適化されたソフトウェア・スタックと最大320ギガバイト(GB)のGPUメモリを使って、大規模なモデルをトレーニングすることができます。

NVIDIA DGX Systems

スペック表

| 販売終了 NVIDIA DGX Station A100 160GB |

販売終了 NVIDIA DGX Station A100 320GB |

販売終了 NVIDIA DGX™ A100 320GB |

販売終了 NVIDIA DGX™ A100 640GB |

NVIDIA DGX™ H100 640GB |

|

|---|---|---|---|---|---|

| 筐体タイプ | タワー型(ワークステーション) | ラックマウント型(サーバ筐体) | ラックマウント型 (サーバ筐体) |

||

| GPU | 4x NVIDIA A100 40GB | 4x NVIDIA A100 80GB | 8x NVIDIA A100 40GB | 8x NVIDIA A100 80GB | 8x NVIDIA H100 Tensor Core |

| 性能 | 2.5 PetaFLOPS AI | 5 PetaFLOPS AI | 32 petaFLOPS FP8 | ||

| GPUメモリ | 160GB(合計) | 320GB(合計) | 640GB(合計) | 640GB(合計) | |

| NVIDIA CUDAコア | 27,648(合計) | 55,296(合計) | ー | ||

| NVIDIA Tensorコア | 1,728(合計) | 3,456(合計) | ー | ||

| CPU 接続バス | NVLink | NVSwitch | NVSwitch | ||

| CPU | Single AMD Rome 7742 2.25GHz(Base) 3.4Ghz(MaxBoost) 64コア |

Dual AMD Rome 7742 2.25GHz(Base) 3.4Ghz(MaxBoost) 128コア |

Dual x86 | ||

| システムメモリ | 512GB | 11TB | 2TB | 2TB | |

| ネットワーク | 2 x 10GbEth 1 x 100MbEth(BMC) |

1 x 1GbEth 8 x 200GbIB 1 x Dual200GbEth 1 x 1GbEth(BMC) |

1 x 1GbEth 8 x 200GbIB 2 x Dual200GbEth 1 x 1GbEth(BMC) |

4x OSFP ports serving 8x singleport NVIDIA ConnectX-7 400Gb/s InfiniBand/Ethernet 2x dual-port NVIDIA BlueField-3 DPUs VPI 1x 400Gb/s InfiniBand/Ethernet 1x 200Gb/s InfiniBand/Ethernet |

|

| ストレージ | OS: 1 x 1.92TB NVMe Date: 7.68TB NVMe |

OS: 2 x 1.92TB NVMe Date: 4 x 3.84TB NVMe |

OS: 2 x 1.92TB NVMe Date: 8 x 3.84TBNVMe |

OS: 2x 1.9TB NVMe Date: 8x 3.84TB NVMe |

|

| 最大消費電力 | 1500W(100V) | 6.5kW(200V) | ~10.2kW | ||

| ソフトウェア | DGX OS Desktop (UbuntuLinuxBase) |

DGX OS Server (UbuntuLinuxBase) |

DGX OS Server (UbuntuLinuxBase) |

||

| サイズ(mm) | 518D x 256W x 639H | 897.1D x 482.3W x 264H | ー | ||