NVIDIA DGX™ プラットフォーム

NVIDIA DGX™ H100

NVIDIA DGX™ プラットフォーム NVIDIA DGX™ H100

NVIDIA DGX™

H100について

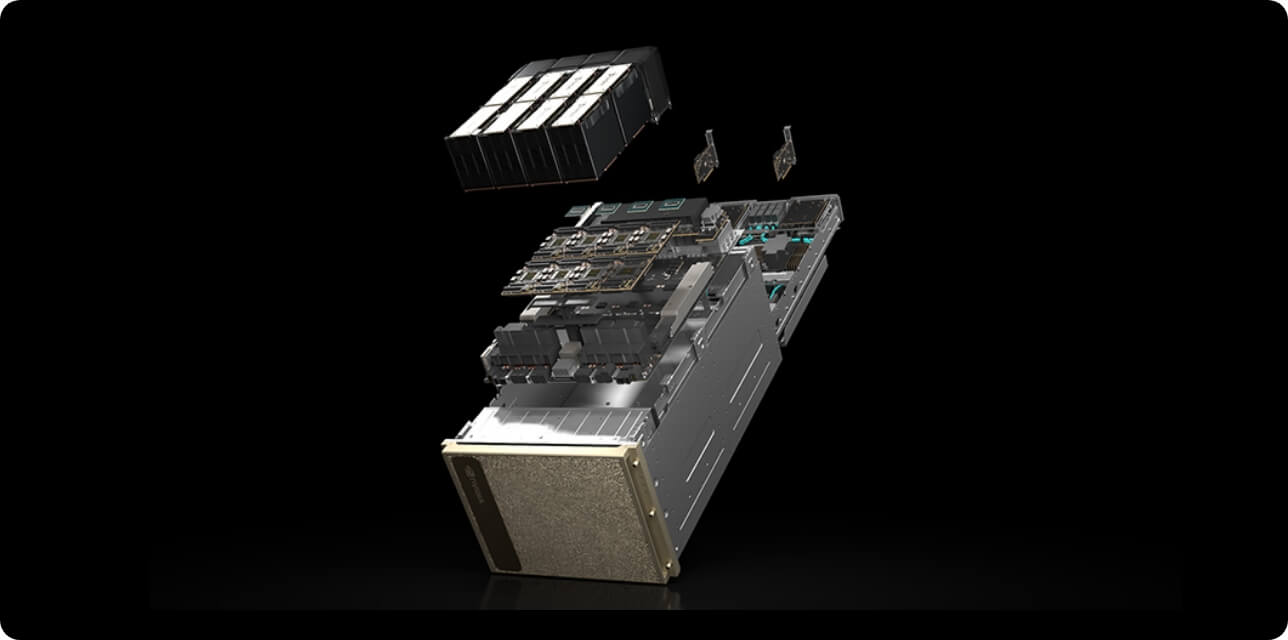

世界のAIインフラを支える新しいエンジンNVIDIA H100を搭載したNVIDIA DGX™ H100は大規模な組織へ最高の AI 環境を提供します。

世界で最も成功したエンタープライズAI専用システムの第4世代です。

NVIDIA DGX™ H100の詳細

-

1

NVIDIA H100 GPU x8

合計 GPU メモリ 640GBGPU あたり 12 NVIDIA® NVLinks®、

GPU 間の双方向帯域幅 900GB/秒 -

2

NVIDIA

NVSWITCHES™ x47.2 テラバイト/秒の GPU 間双方向帯域幅、

前世代比 1.5 倍以上 -

3

NVIDIA ConnectX-7 Single Port Infiniband Card x8

および、NVIDIA ConnectX-7

Dual Port Ethernet cards x2ピーク時の双方向ネットワーク

帯域幅 1TB/秒 -

4

デュアル x86 CPU と

2TB システム メモリAI への依存が

非常に高い仕事を

可能にするパワフルな CPU -

5

30TB NVME SSD

最高のパフォーマンスを

実現するための

高速ストレージ

製品 比較表

| Specification | NVIDIA DGX™ H100 |

|---|---|

| GPUs | 8x NVIDIA H100 GPUs |

| TFLOPS | 32 Peta FLOPS FP8 |

| GPU Memory | 80GB per GPU/640 GB per DGX H100 Node |

| System Memory | 2TB |

| Storage | Data cache drives: 30TB (8x3.84TB) OS drives: 2x 1.92TB NVME SSDs |

| Network | 4 x OSFP ports for 8 NVIDIA ConnectX-7 Single Port InfiniBand cards Ethernet: 400/200/100/50/40/ 25/10Gb/s InfiniBand: Up to 400Gbps 2 x NVIDIA ConnectX-7 Dual Port Ethernet cards Ethernet: 400/200/100/50/40/ 25/10Gb/s InfiniBand: Up to 400Gbps |

| Cooling | Air |